赶在微软 Build 2019 的第二天,Google I/O 如期到来。有趣的是,与去年一样,在 Build 2019 的西雅图场地中,微软也贴心而大方地现场直播了这场由 Google 打造的同样举办在美国西海岸的科技盛会。只不过,与 Bulid 大会相比,Google I/O 除了同样吸引开发者之外,也会展现不少与移动互联网、Android 生态、智能手机 App 等相关的元素,从而更受到普通用户群体的关注。

当然,与 Bulid 一样,Google I/O 最值得关注的是在大会第一天进行的 Keynote 环节,主持这一环节的正是 Google CEO Sundar Pichai;在经历了一番前瞻之后,来带大家看看本次 Google I/O 究竟有哪些亮点。

Google Search 呈现3D模型和AR效果

当地时间 5 月 7 日上午十点钟,伴随着一段炫酷的视频,Google I/O 正式开始。Goolge CEO Sundar Pichai 首先登台,介绍了 Google Search 的重大更新——3D 模型 + AR。

举例来说,当用户在 Google 中搜索 “鲨鱼” 时,在搜索列表中会呈现鲨鱼的 3D 模型;点击之后,用户可以对 3D 模型进行触控;如果点击界面中的 AR 选项,则可以看到鲨鱼模型在现实生活中的场景。

可以说是非常炫酷了。

需要注意的是,Google Search 之所以能够呈现 3D 模型,实际上是得益于 Google 与合作伙伴的合作。Google 表示正在与 NASA、New Balance、Samsung、Target、Visible Body、Volvo、Wayfair 等企业或机构合作,以便在搜索结果中呈现更多的 3D 内容。

更强大的Google Lens

Google Lens 发布于 2017 年,在本次 Google I/O 中,它也得到了重大更新;具体如下:

当用户在餐厅中用 Google lens 扫描菜单时,Google Lens 可以自动推荐最受欢迎的餐品,点击之后可以直接看到食物照片和用户评价。

Google Lens 可以直接对车票等上的文字信息进行识别并实时翻译,然后自然地覆盖在原有的文字信息上。

通过与相关的合作,当用户用 Google Lens 扫描呈现在 Bon Appetit 杂志中菜品时,甚至可以直接在画面中看到这个菜品的动态制作过程。

简单来说,就是 Google Lens 更好地与 Google Maps、计算机视觉、AR 等技术相结合,从而为用户带来更多便利的功能。

不再依赖网络的Google Assistant

作为 Google 旗下最为重要的智能助手,Google Assistant 现在覆盖了超过 10 亿台设备,在 80 个国家/地区提供 30 多种语言,并与全球 3500 多个品牌的超过 30000 台独特的家庭连接设备合作。

在本次大会上,Google Assistant 也迎来了一个重大更新——新一代 Google Assistant。

Google 表示,在不断发展的神经网络的基础上,该公司开发了全新的语音识别和语言理解模型,将云计算中 100GB 的模型降到不到半 GB,也就是说,AI 驱动的 Google Assistant 现在可以在用户的手机上本地运行。由此,Google Assistant 可以手机上以几乎零延迟处理语音,即使在没有网络连接的情况下,也可以实时进行使用。

Google 表示,基于本地部署优势,下一代 Google Assistant 将以 10 倍的速度理解和处理用户指令并给出答案;无论是跨应用操作、还是多轮对话,都能够轻松进行。

基于网页的Duplex

在 Google I/O 2018,Google 发布的 Duplex 功能,可以帮助用户打电话订餐;如今,Google 将 Duplex 带到了网页上。

具体来说,用户只要问 Google Assistant,“为我的下一次旅行预订一辆全国通用的车”,剩下的交给 Google Assistant 就可以。它可以将导航该站点并输入用户信息,如保存在 Gmail 中的旅行详情或保存在 Chrome 中的付款信息——非常方便。

Google 方面表示,Duplex On Web 将在今年晚些时候在美国和英国地区的 Android 手机中上线,提供英文版,可以为租车和电影票提供助手服务。

Google Assistant驾驶模式

今年早些时候,Google Assistant 被整合在 Google Maps 中;不过这一次,Google Assistant 推出了全新的驾驶模式。

Google 驾驶模式的核心交互是语音。用户可以用它来实现导航、发信息、电话呼叫和播放音乐等操作。它也可以用户提供建议建议,比如用户在日历上预订了晚餐,将能够看到餐厅的导航;或者,如果你在家里开始播放音乐,可以在离开车的地方重新开始;如果有人打来电话,Google Assistant 会告诉用户是谁打来的,并询问是否愿意接听。

在启动方式上,当用户手机连接到汽车蓝牙或者直接说 “嘿,Google,我们开车吧”,助手的驾驶模式就会自动启动。

最后,该模式将于今年夏天在 Android 手机上与 Google Assistant 一起提供。

Google Assistant闹铃彩蛋

简单来说,当用户家中的 Google Home 音箱开始在早上变身闹铃唤醒用户时,一句 Stop 就可以继续睡觉了,不用再专门呼叫 Google Assistant。

AI 向善:帮助ALS患者更好地表达沟通

在本次 Google I/O 中,Google 也表现出了 AI 向善的一面,利用 AI 帮助部分群体解决沟通问题。

具体来说,针对 ALS (肌萎缩侧索硬化)患者的沟通问题,Google 开发了一个语音识别模型,专门针对的这些患者的发音进行训练,以便更好地识别他们所表达的内容,从而形成文字呈现出来,以便让他们更好地沟通。

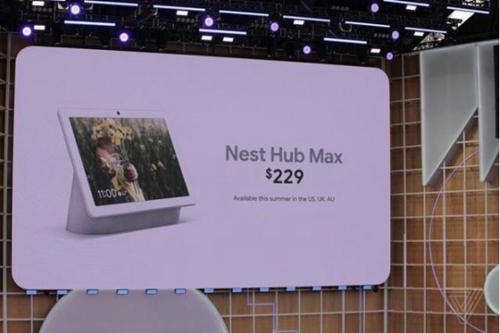

Nest Hub Max:229 美元起

此前,Google Store 中曾出现关于“Nest Hub Max”的相关信息,不过很快就被移除了。在本次的 I/O 大会上,Nest Hub Max 的神秘面纱被揭开。

无论是在配置上,还是在功能上,Nest Hub Max 与之前的 Home Hub(该产品已经被重新命名为 Nest Hub)有点类似。不过,Nest Hub Max 具备了 Home Hub 并不具备的安全功能,也增加了一颗前置摄像头(可以通过一个物理按钮关闭来保护隐私)。当用户出门在外时,可以通过这款产品上装置的摄像头来观察家里的情况,如果 Nest Hub Max 检测到家里有陌生人,也会及时向用户发送信息。

Nest Hub Max 还有一个更加人性化的改进——手势识别技术。有了这项技术,用户在与设备进行交互时甚至可以不用发声,只需要看着摄像头,把手抬起来做一个手势就好。

Nest Hub Max 售价 229 美元,今年夏天在美国开售;另外,它在英国和澳大利亚的价格分别是 219 英镑和 349 澳元。

联合学习:Federated Learning

2017 年,Google 曾经发表过一篇介绍联合学习技术的博客,这一技术的重要特点就是在保护数据隐私的情况下来进行学习——它能够在不共享数据的情况下怎么能过来挖掘数据内在的价值,也就是在兼顾数据隐私的情况下同时又能提供智能服务。

以医疗为例,首先在不同医院用它自己的数据训练出来不同的模型,然后把这些模型送到中心处理器并整合为一个完美模型;当每个医院不停获取数据,通过把最新的完美模型下载到医院端,并将新数据导入,再推送回中心服务器;通过这样的步骤,新的数据不会被交换出去,被交换的只有模型,所以数据也不会被反向揭露。

在本次 Google I/O 中,Google 提到了联合学习,并表示它已经在 Gboard 应用中得到使用。

总结

毫无疑问,对于 AI First 的 Google 来说,已经无处不在地体现在它的产品和战略中,无论是硬件还是软件;而伴随着 Google 自身在技术方面的进展,它也在 AI 与用户需求实现更加深入的贴合,让这一次的 Google I/O 变得非常炫酷。也能够感受到,AI、AR 也越来越成为移动智能设备的下一个关键词。

当然,作为一个科技巨头,Google 也正在本次 Google I/O 上着力强调更加正确的价值观——Building a more helpful Google for everyone,比如说利用 AI 帮助残疾人和病患群体、对用户隐私和安全保护的重点强调等。当科技越来越走向人们的生活,它的价值观问题就越来越值得深思——某种意义上,这是 Google 的责任所在,也是诸多科技公司自身发展的责任所在。